APTO Inc.

生成AI活用が拡がる今、精度は最も重要な指標であり、導入や活用の判断基準です。APTOはこれからも、AIデータを通じて企業・組織の事業活動を支援して参ります。

近年、LLMの性能は飛躍的に向上していますが、複数ステップの計算や厳密な解答形式を要求される数理タスクでは、依然として誤答や形式不備が散見されます。これらの課題に対応するため、数理推論の思考・回答精度を高めることを目的とし、LLM学習用データセットを開発、公開しました。

数理推論用LLMデータセット開発の背景

LLM開発者およびLLM利用者は、以下のような数学応用における課題を経験されたことがあると思います。

・段階的な計算を出力しない

・計算プロセスを正確に踏まず、解答を誤る

・整数や分数など、指定された解答フォーマットに従わない出力

・途中式の記載漏れや最終解答のみの出力など、問題へのアプローチが見えない解答

このように複雑な数理問題の回答において、指示やルールを無視し正確なアウトプットが行われないという経験をされた方も多いと思います。

そこで数学問題の解答精度を改善するために、これまでの当社のLLMの思考能力改善のノウハウを活かし、複雑な思考プロセスを含む数学問題データセットの開発を行いました。

本データセットの内容について

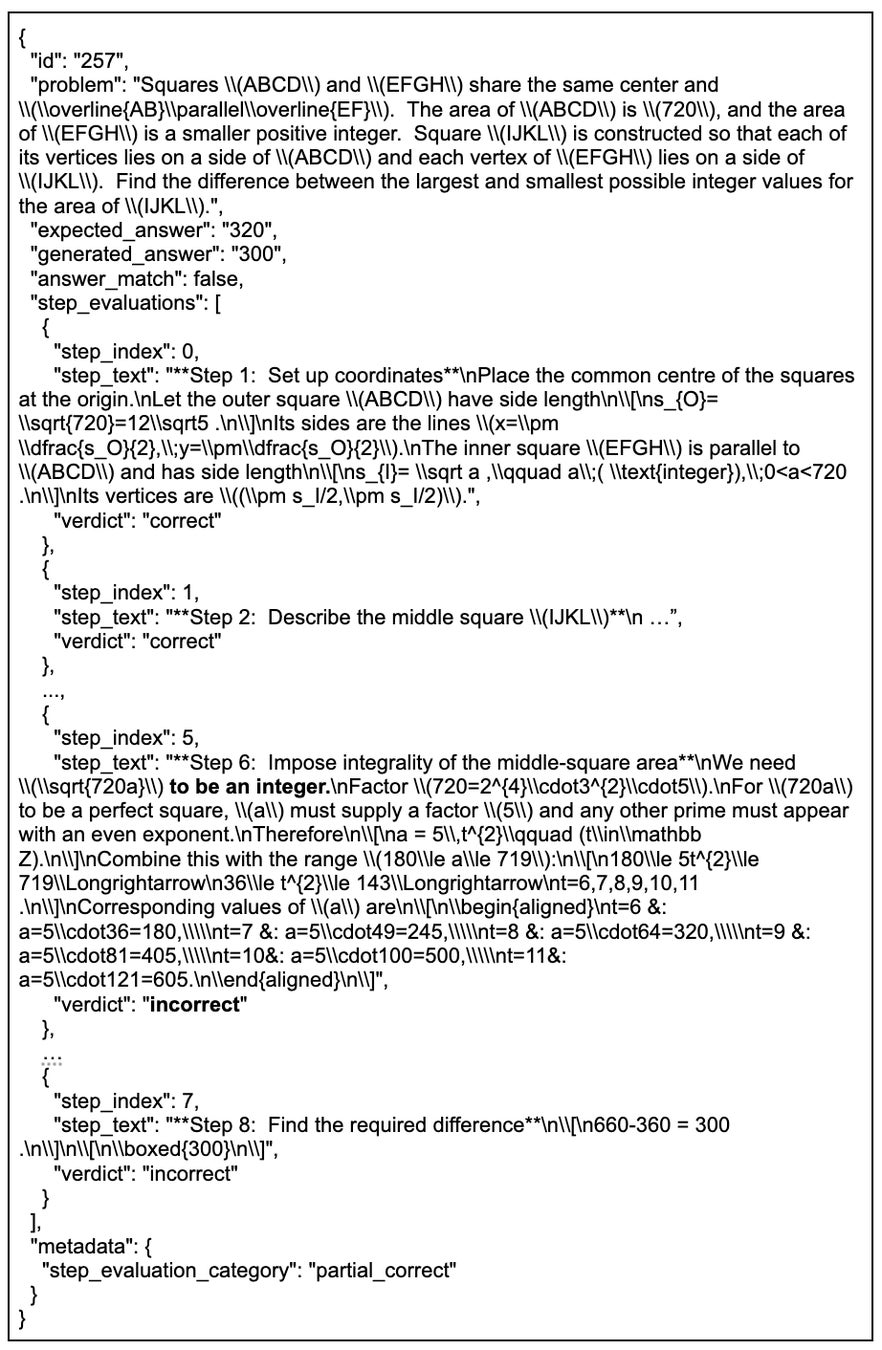

本データセットは、自動生成と人手検証を組み合わせたJSONL形式の数理推論データです。PRM(Process/Preference Reward Model)学習を想定し、問題文、正解、生成解答に加え、思考過程(Chain-of-Thought)と各ステップの評価情報を含めています。これにより、単なる正誤判定だけでなく推論プロセスの質的評価を可能にしました。

データセットに含まれる内容

・problem:問題文(入力する数学問題)

・expected_answer:正解(自動採点や評価、フォーマットチェックに活用)

・generated_answer:モデルが生成した解答(誤答傾向分析や難例抽出に活用)

・answer_match:最終正誤フラグ(難易度調整・層別評価・サンプリング制御に活用)

・step_evaluations(配列;各要素が {step_index, step_text, verdict}):各ステップのテキストと正誤ラベルを用いてPRM/プロセス監督を実施

・metadata.step_evaluation_category(例:all_correct / partial_correct):カリキュラム学習や Best‑of‑N による再採点時の重み付けに有効

思考プロセスが途中で破綻してしまう例

この例では、幾何的制約を一部見落としたまま『面積が整数になる』という数論的条件だけで範囲を限定しています。そのため、本来許されない配置まで含めており、差を 300 と誤って結論づけています。一方で、前半の導出は正しく、最後で崩れる典型パターンとして partial_correct に分類されています。

※この一例は代表的な誤答例であり、公開データ全体の一部です。

当社では、自動評価と一部人手検証を組み合わせることで、形式遵守と最終正答の両面から品質を管理しています。今回公開しているデータセットは、学習に使用したデータのうち300件を抽出して、公開しております。

問題のジャンルについて

思考プロセスが特定ジャンルに偏らないよう、問題のジャンルは以下のように分けております。

1. 解析

2. 代数

3. 幾何学

4. 確率・統計・離散数学

思考過程について

「思考過程(Chain-of-Thought)」 とは数学問題を解く際の段階的な思考プロセスを指しています。

問題を読み、段階的に計算を進めながら解答に至る適切なプロセスを構造化したデータになっています。最低でも2つの推論過程を含めており、2段階〜8段階で解答を出す計算過程を持たせています。

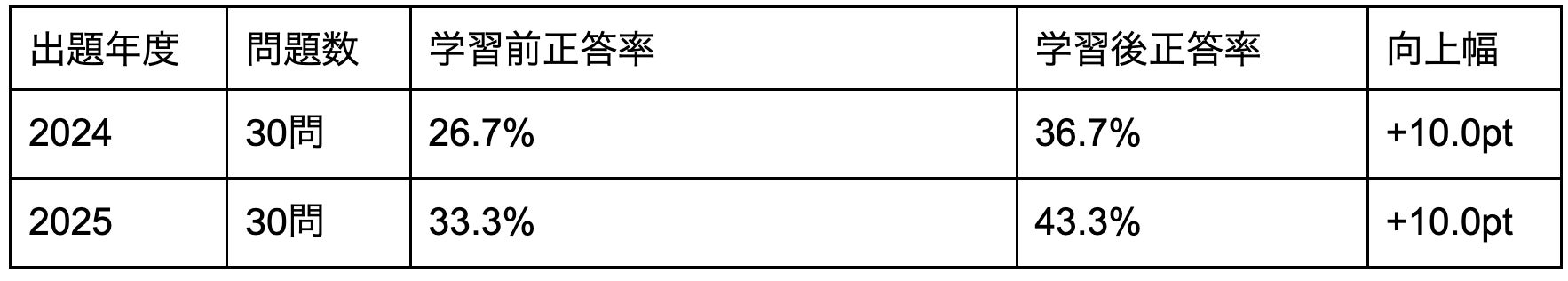

データの性能検証結果

このデータセットを用いて学習したモデルでは、以下のAIME問題セットを外部ベンチマークとして性能検証を行いました。

2024年AIME(HuggingFaceH4/aime_2024) ※1

2025年AIME(math-ai/aime25) ※2

具体的な検証方法は以下のようになります。

1.数学解答における適切な思考データを学習データとして Fine Tuning(以下FT)。

本FTは、PRM(Process Reward Model) と CLM(因果言語モデリング) を組み合わせたマルチタスクです。

PRMではデータセットの step_evaluations.step_text を入力、verdict(本データでは3値:“correct/incorrect/unclear”)を教師信号としてステップ正誤の分類損失を学習し、CLM(次トークン予測)を併用して文章生成能力の維持を図りました。学習手法は LoRA を採用し、ベースモデルを主に凍結したまま効率的に微調整しています。

2.AIMEデータセットで学習前後の解答精度を評価。出力が異なることもあるため、同様の解答を4回した上でそのスコアの平均を比較。

解答精度の改善を評価するため、以下の高い数学性能を持つモデルに対して評価を行いました。

openai/gpt-oss-20b ※3

上記のモデルに対して学習を行ったところ、実際に10.0ポイントの解答性能の改善が見られました。

以下がそのスコア表となります。

複雑な計算プロセスを含むデータを用いることで、数理推論タスクの解答精度向上に加え、段階的な計算が破綻しなくなったと考えられます。

当該データセットにつきましては、以下 Hugging Faceでも公開しております。

https://huggingface.co/datasets/APTOinc/llm-math-reasoning-dataset

既にお取引があるお客様につきましては、メールマガジンより近日配信予定でございます。

今後のデータセット作成について

理屈に則った推論を必要とする領域では、複雑な過程の正確な理解や正解にたどり着くためのプロセスに再現性が求められ、推論過程そのものの質を重視する手法が注目されています。※4

LLMの技術進歩は極めて早いため、当社では、転々とするニーズや技術課題を意識しながら、他の分野にも段階的なプロセスを正確に辿るためのデータセットを作る必要があると考えております。

今後の技術動向やお客様のニーズに応じて、新たなデータセットの作成を進めております。みなさまのAI開発の加速、そして精度のさらなる向上にお役立ていただければ幸いです。是非ご活用ください。

脚注

※1: https://huggingface.co/datasets/HuggingFaceH4/aime_2024

※2: https://huggingface.co/datasets/math-ai/aime25

※3: https://huggingface.co/openai/gpt-oss-20b

※4: The Lessons of Developing Process Reward Models in Mathematical Reasoning (2025), https://arxiv.org/abs/2410.17621

株式会社APTO

あらゆるAI開発において、最も精度に影響を与える「データ」にフォーカスしたAI開発支援サービスを提供しております。クラウドワーカーを活用したデータ収集・アノテーションプラットフォーム「harBest」や、初期段階でボトルネックになるデータの準備を高速化する「harBest Dataset」、専門家の知見を活用してデータの精度を上げる「harBest Expert」など、データが課題で進まないAI開発を支援することで多くの国内外のエンタープライズ様に評価をいただいております。

▼地球最速のデータ収集・作成プラットフォーム「harBest」

▼データ収集・作成ポイ活アプリ「harBest」

https://harbest.site

▼専門領域特化型LLM Instruction Data Stock「harBest Expert」

会社名 :株式会社APTO

所在地 :東京都渋谷区神南1-5-14三船ビル4F 403号室

代表者 :代表取締役 高品 良

URL :https://apto.co.jp/

AI開発やAI開発におけるデータまわりで課題感をお持ちでしたら是非ご相談ください。